Langfuse 与 OpenWebUI 的集成

Langfuse (GitHub)为 OpenWebUI 提供开源的可观测性和评估工具。通过启用 Langfuse 集成,您可以追踪应用程序数据,从而开发、监控并改进 OpenWebUI 的使用体验,包括:

如何将 Langfuse 与 OpenWebUI 集成

Langfuse 集成步骤

Langfuse 集成步骤

OpenWebUI 中的 Pipelines 是一个与 UI 无关的框架,用于 OpenAI API 插件。它允许注入插件,这些插件可以拦截、处理并将用户提示转发给最终的语言模型(LLM),从而增强对提示处理的控制和自定义。

要使用 Langfuse 跟踪您的应用程序数据,您可以使用 Langfuse Pipeline,该管道支持实时监控和分析消息交互。

快速入门指南

第一步:设置 OpenWebUI

确保 OpenWebUI 已经运行。为此,请参阅 OpenWebUI 文档。

第二步:设置 Pipelines

通过 Docker 启动 Pipelines。使用以下命令启动 Pipelines:

docker run -p 9099:9099 --add-host=host.docker.internal:host-gateway -v pipelines:/app/pipelines --name pipelines --restart always ghcr.io/open-webui/pipelines:main

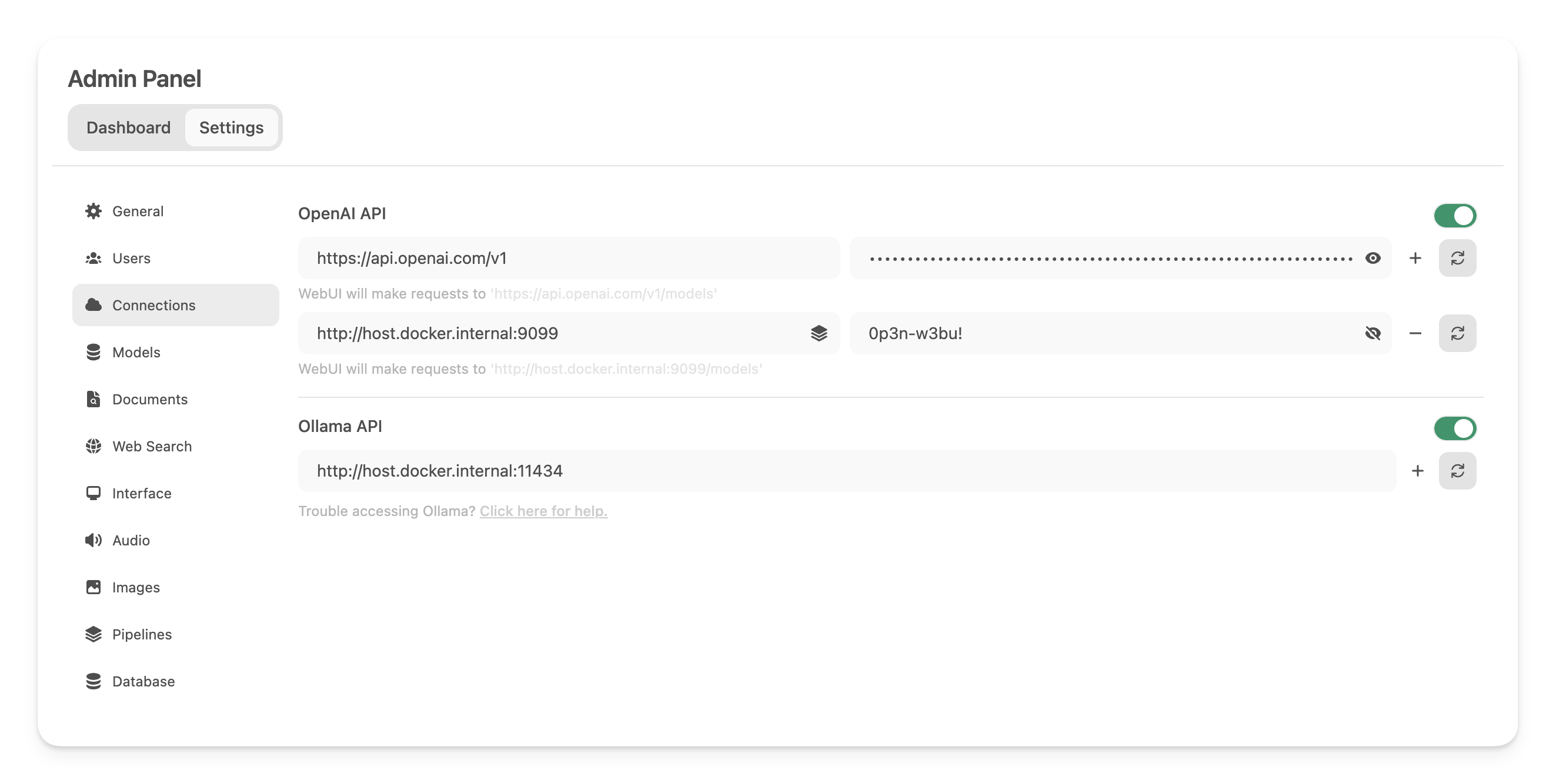

第三步:连接 OpenWebUI 和 Pipelines

在 管理设置 中,创建并保存一个新的 OpenAI API 类型连接,并填写以下信息:

- URL: http://host.docker.internal:9099 (这是之前启动的 Docker 容器所在的地址)

- 密码: 0p3n-w3bu! (默认密码)

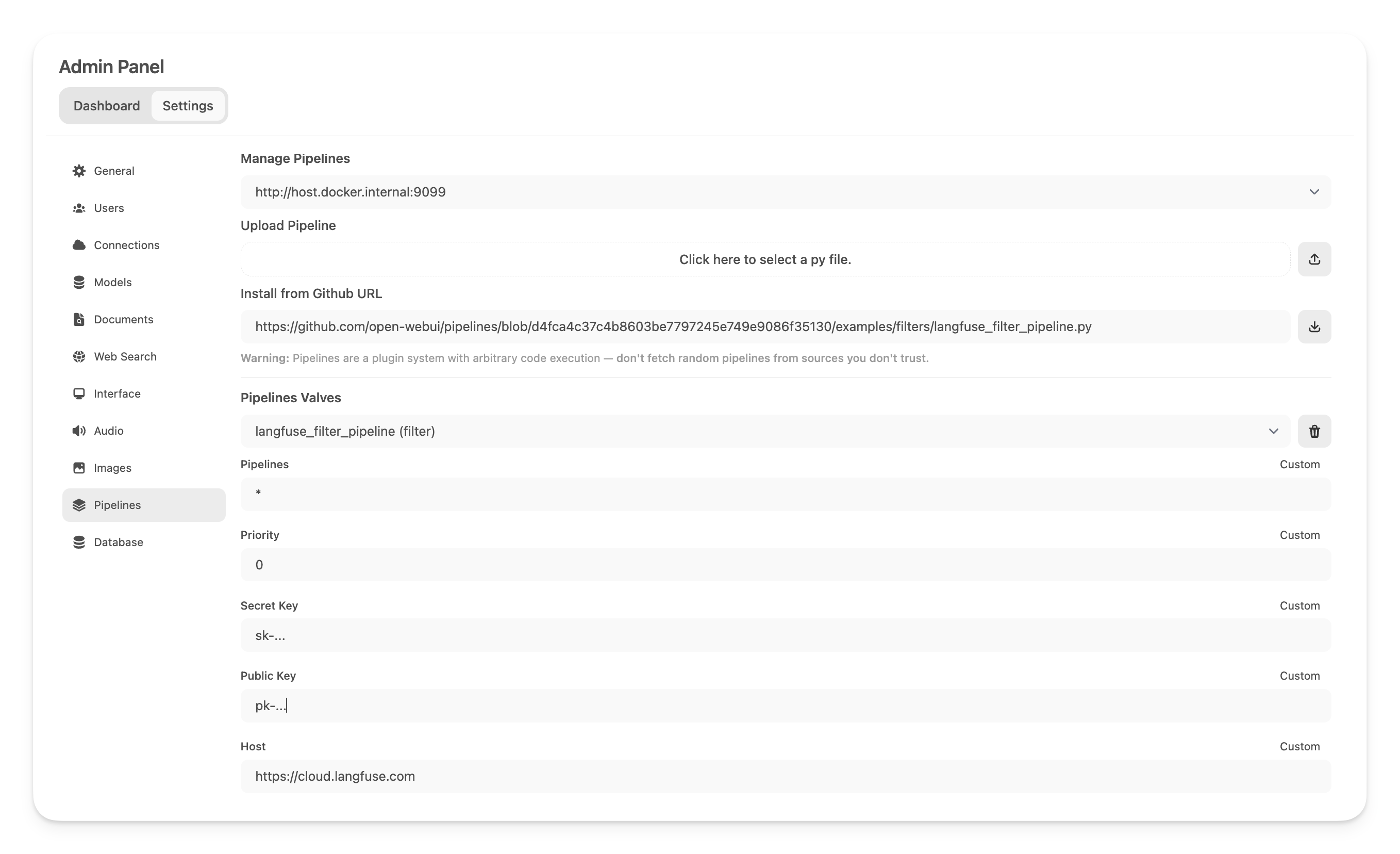

第四步:添加 Langfuse Filter Pipeline

接下来,在 管理设置 -> Pipelines 中添加 Langfuse Filter Pipeline。指定 Pipelines 监听的地址为 http://host.docker.internal:9099(如前所配置),并通过 从 GitHub URL 安装 选项安装 Langfuse Filter Pipeline,使用以下 URL:

https://github.com/open-webui/pipelines/blob/main/examples/filters/langfuse_filter_pipeline.py

现在,在下方输入您的 Langfuse API 密钥。如果您尚未注册 Langfuse,可以通过 这里 创建账户获取 API 密钥。

注意: 在启用流式传输时捕获 OpenAI 模型的使用情况(令牌计数),您需要导航到 OpenWebUI ��中的模型设置,并勾选“能力”下的“使用情况”框。

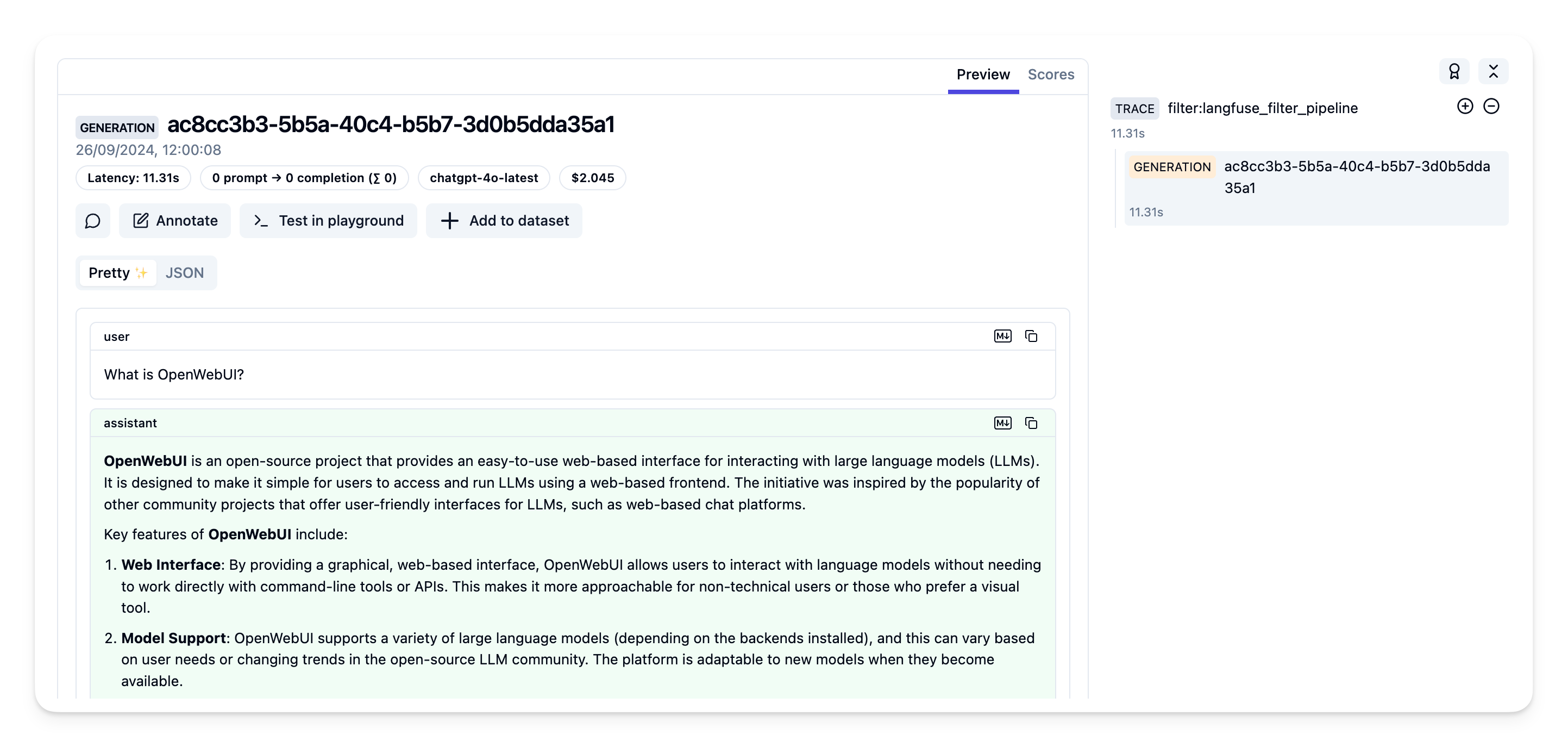

第五步:在 Langfuse 中查看跟踪

现在,您可以与 OpenWebUI 应用程序进行交互,并在 Langfuse 中查看跟踪记录。

示例跟踪 在 Langfuse 界面中:

了解更多

有关 OpenWebUI Pipelines 的详细指南,请访问 这篇文章。